Firefly, la familia de modelos de IA generativa de Adobe, no tiene la mejor reputación entre los creativos.

El modelo de generación de imágenes Firefly en particular ha sido ridiculizado como decepcionante y defectuoso en comparación con Midjourney, DALL-E 3 de OpenAI y otros rivales, con una tendencia a distorsionar las extremidades y los paisajes y perder los matices en las indicaciones. Pero Adobe está tratando de enderezar el barco con su modelo de tercera generación, Firefly Image 3, lanzado esta semana durante la conferencia Max London de la compañía.

El modelo, ahora disponible en Photoshop (beta) y la aplicación web Firefly de Adobe, produce imágenes más “realistas” que su predecesor (Imagen 2) y su predecesor (Imagen 1) gracias a la capacidad de comprender indicaciones y escenas más largas y complejas. así como capacidades mejoradas de iluminación y generación de texto. Debería representar con mayor precisión cosas como tipografía, iconografía, imágenes rasterizadas y arte lineal, dice Adobe, y es “significativamente” más hábil para representar multitudes densas y personas con “características detalladas” y “una variedad de estados de ánimo y expresiones”.

Por si sirve de algo, en mis breves pruebas no científicas, Imagen 3 hace Parece ser un paso adelante con respecto a la Imagen 2.

Yo mismo no pude probar la Imagen 3. Pero Adobe PR envió algunos resultados y mensajes del modelo, y logré ejecutar esos mismos mensajes a través de la Imagen 2 en la web para obtener muestras con las que comparar los resultados de la Imagen 3. (Tenga en cuenta que los resultados de la Imagen 3 podrían haber sido seleccionados cuidadosamente).

Observe la iluminación en esta foto de la Imagen 3 en comparación con la que está debajo, de la Imagen 2:

De la imagen 3. Mensaje: “Retrato de estudio de una mujer joven”.

El mismo mensaje que el anterior, de la Imagen 2.

La salida de la Imagen 3 parece más detallada y realista a mis ojos, con sombras y contraste que están en gran medida ausentes en la muestra de la Imagen 2.

Aquí hay un conjunto de imágenes que muestran la comprensión de la escena de la Imagen 3 en juego:

De la imagen 3. Mensaje: “Una artista en su estudio sentada en un escritorio luciendo pensativa con toneladas de pinturas y etérea”.

El mismo mensaje que el anterior. De la imagen 2.

Tenga en cuenta que la muestra de la Imagen 2 es bastante básica en comparación con el resultado de la Imagen 3 en términos de nivel de detalle y expresividad general. Hay confusión con el sujeto en la camisa de la muestra de la Imagen 3 (alrededor del área de la cintura), pero la pose es más compleja que la del sujeto de la Imagen 2. (Y la ropa de la Imagen 2 también está un poco fuera de lugar).

Sin duda, algunas de las mejoras de la Imagen 3 se pueden atribuir a un conjunto de datos de entrenamiento más grande y diverso.

Al igual que la Imagen 2 y la Imagen 1, la Imagen 3 está entrenada para cargas en Adobe Stock, la biblioteca multimedia libre de derechos de autor de Adobe, junto con contenido de dominio público y con licencia cuyos derechos de autor han expirado. Adobe Stock crece todo el tiempo y, en consecuencia, también lo hace el conjunto de datos de entrenamiento disponible.

En un esfuerzo por evitar demandas y posicionarse como una alternativa más “ética” a los proveedores de IA generativa que entrenan con imágenes indiscriminadamente (por ejemplo, OpenAI, Midjourney), Adobe tiene un programa para pagar a los contribuyentes de Adobe Stock por el conjunto de datos de entrenamiento. (Sin embargo, notaremos que los términos del programa son bastante opacos). De manera controvertida, Adobe también entrena modelos de Firefly en imágenes generadas por IA, lo que algunos consideran una forma de lavado de datos.

Bloomberg reciente informar Las imágenes reveladas generadas por IA en Adobe Stock no están excluidas de los datos de entrenamiento de los modelos de generación de imágenes de Firefly, una perspectiva preocupante considerando que esas imágenes podrían contener material regurgitado con derechos de autor. Adobe ha defendido la práctica, afirmando que las imágenes generadas por IA constituyen sólo una pequeña parte de sus datos de entrenamiento y pasan por un proceso de moderación para garantizar que no representen marcas comerciales, personajes reconocibles o nombres de artistas de referencia.

Por supuesto, ni los datos de capacitación diversos y de origen más “ético” ni los filtros de contenido y otras salvaguardas garantizan una experiencia perfectamente libre de fallas: vea a los usuarios generar gente volteando el pájaro con la Imagen 2. La verdadera prueba de la Imagen 3 llegará una vez que la comunidad la tenga en sus manos.

Nuevas funciones impulsadas por IA

Image 3 potencia varias características nuevas en Photoshop más allá de la conversión de texto a imagen mejorada.

Un nuevo “motor de estilo” en la Imagen 3, junto con una nueva opción de estilización automática, permite al modelo generar una gama más amplia de colores, fondos y poses de los sujetos. Se alimentan de Imagen de referencia, una opción que permite a los usuarios condicionar el modelo a una imagen con cuyos colores o tono desean que se alinee su contenido generado en el futuro.

Tres nuevas herramientas generativas (Generar fondo, Generar similar y Mejorar detalles) aprovechan Imagen 3 para realizar ediciones de precisión en las imágenes. Generar fondo (autodescriptivo) reemplaza un fondo con uno generado que se combina con la imagen existente, mientras que Generar similar ofrece variaciones en una parte seleccionada de una foto (una persona o un objeto, por ejemplo). En cuanto a Mejorar detalle, “afina” las imágenes para mejorar la nitidez y la claridad.

Si estas características le suenan familiares, es porque han estado en versión beta en la aplicación web Firefly durante al menos un mes (y Midjourney durante mucho más tiempo). Esto marca su debut en Photoshop, en versión beta.

Hablando de la aplicación web, Adobe no descuida esta ruta alternativa hacia sus herramientas de inteligencia artificial.

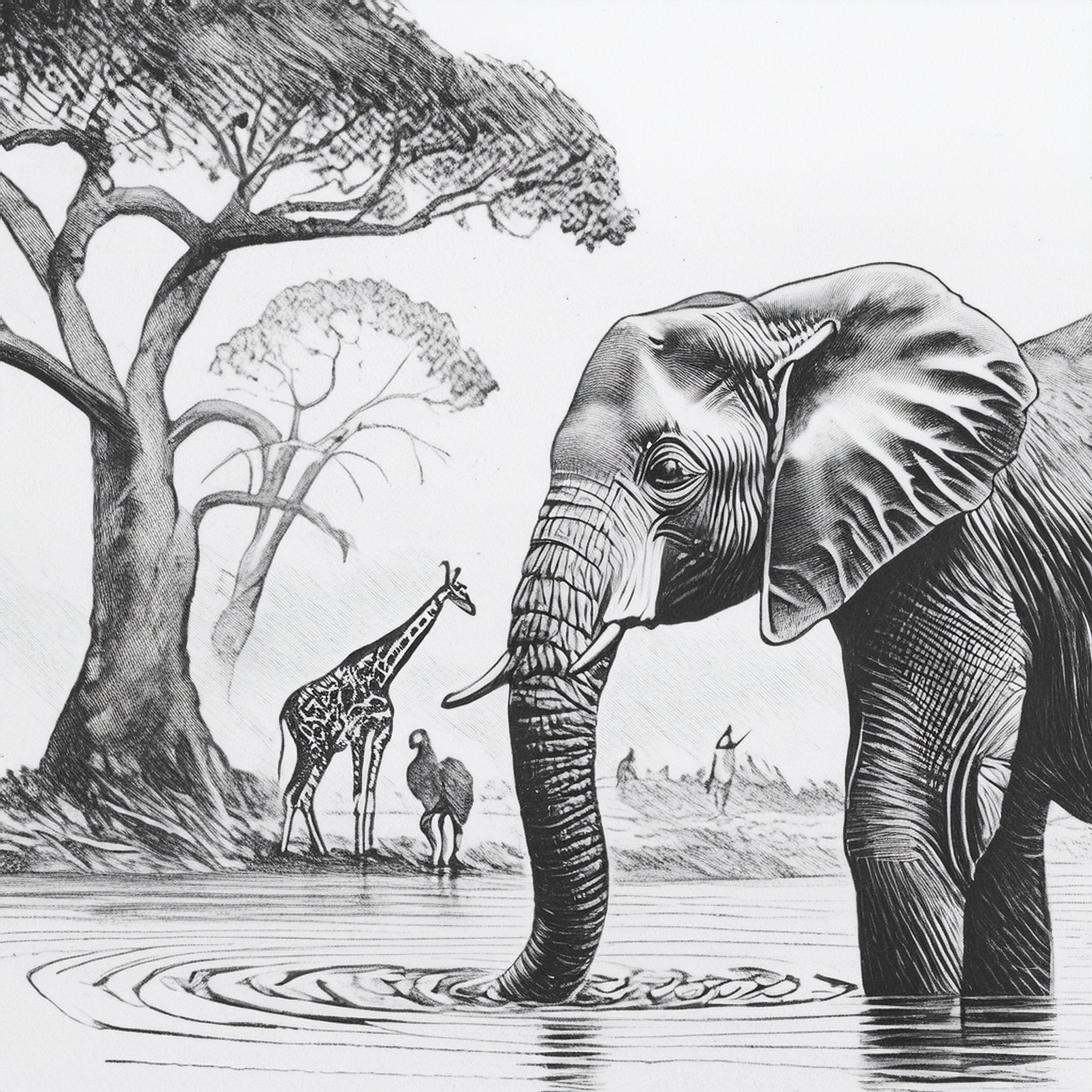

Coincidiendo con el lanzamiento de la Imagen 3, la aplicación web Firefly recibirá Referencia de estructura y Referencia de estilo, que Adobe presenta como nuevas formas de “avanzar en el control creativo”. (Ambas fueron anunciadas en marzo, pero ahora están ampliamente disponibles). Con Structure Reference, los usuarios pueden generar nuevas imágenes que coincidan con la “estructura” de una imagen de referencia, por ejemplo, una vista frontal de un auto de carreras. La referencia de estilo es esencialmente una transferencia de estilo con otro nombre, que preserva el contenido de una imagen (por ejemplo, elefantes en el safari africano) mientras imita el estilo (por ejemplo, un boceto a lápiz) de una imagen de destino.

Aquí está la referencia de estructura en acción:

Imagen original.

Transformado con referencia de estructura.

Y referencia de estilo:

Imagen original.

Transformado con referencia de estilo.

Le pregunté a Adobe si, con todas las actualizaciones, el precio de generación de imágenes de Firefly cambiaría. Actualmente, el plan premium más barato de Firefly cuesta $ 4,99 por mes, lo que socava la competencia como Midjourney ($ 10 por mes) y OpenAI (que ofrece DALL-E 3 detrás de una suscripción ChatGPT Plus de $ 20 por mes).

Adobe dijo que sus niveles actuales permanecerán vigentes por ahora, junto con su sistema de crédito generativo. También dijo que su política de indemnización, que establece que Adobe pagará las reclamaciones de derechos de autor relacionadas con las obras generadas en Firefly, tampoco cambiará, ni su enfoque para marcar el contenido generado por IA. Las credenciales de contenido (metadatos para identificar medios generados por IA) seguirán adjuntándose automáticamente a todas las generaciones de imágenes de Firefly en la web y en Photoshop, ya sea que se generen desde cero o se editen parcialmente mediante funciones generativas.