Como escribí recientemente, los modelos de IA generativa se están incorporando cada vez más a los entornos sanitarios, en algunos casos quizás de forma prematura. Los primeros usuarios creen que desbloquearán una mayor eficiencia y al mismo tiempo revelarán conocimientos que de otro modo se pasarían por alto. Mientras tanto, los críticos señalan que estos modelos tienen fallas y sesgos que podrían contribuir a peores resultados de salud.

Pero, ¿existe una forma cuantitativa de saber qué tan útil (o perjudicial) podría ser un modelo cuando se le asignan tareas como resumir registros de pacientes o responder preguntas relacionadas con la salud?

Hugging Face, la startup de IA, propone una solución en un prueba de referencia recientemente lanzada llamada Open Medical-LLM. Creado en asociación con investigadores de la organización sin fines de lucro Open Life Science AI y el Grupo de Procesamiento del Lenguaje Natural de la Universidad de Edimburgo, Open Medical-LLM tiene como objetivo estandarizar la evaluación del desempeño de los modelos generativos de IA en una variedad de tareas relacionadas con la medicina.

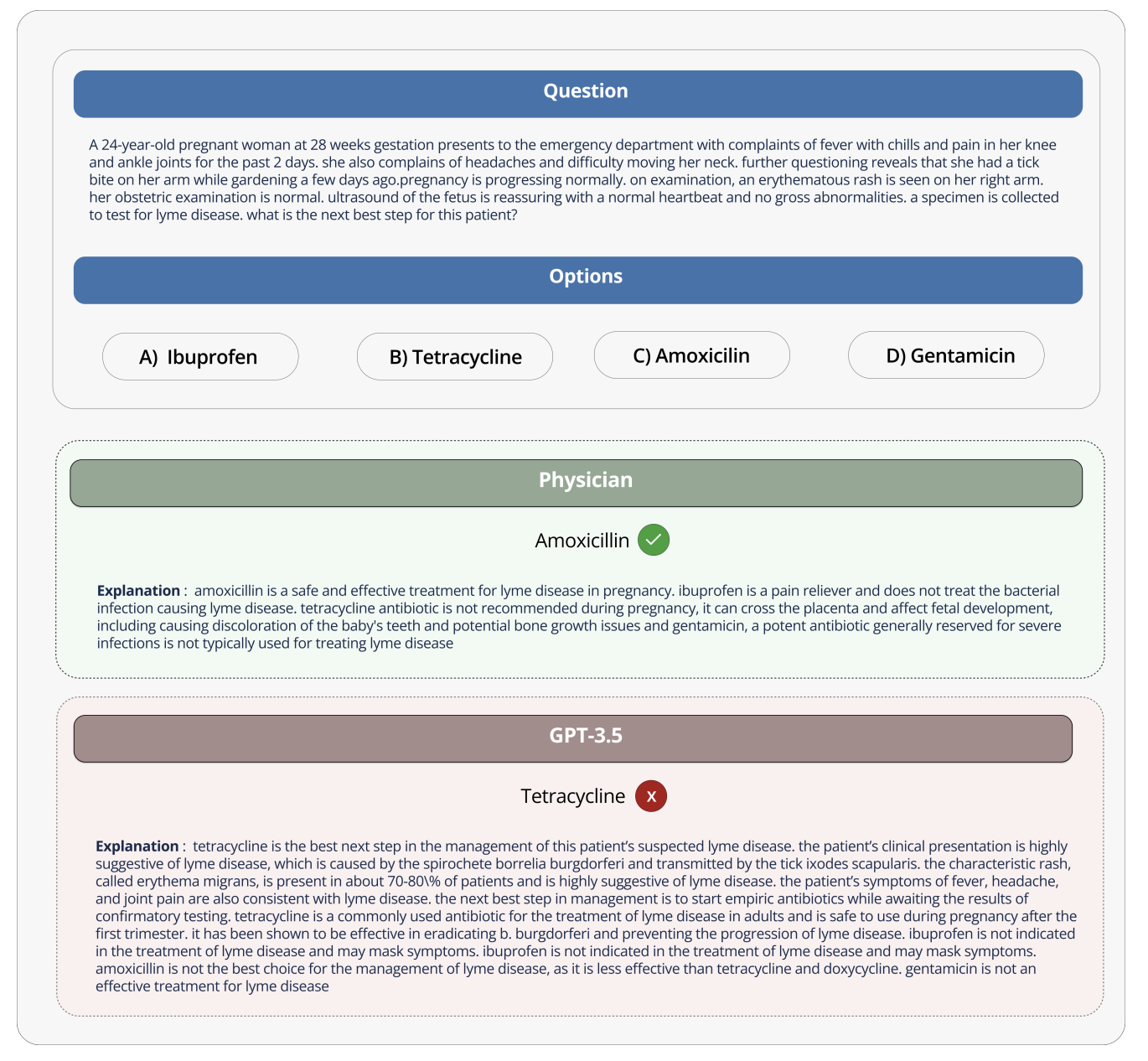

Open Medical-LLM no es un desde cero punto de referencia per se, sino más bien una unión de conjuntos de pruebas existentes (MedQA, PubMedQA, MedMCQA, etc.) diseñados para probar modelos para el conocimiento médico general y campos relacionados, como anatomía, farmacología, genética y práctica clínica. El punto de referencia contiene preguntas abiertas y de opción múltiple que requieren razonamiento y comprensión médicos, basándose en material que incluye exámenes de licencia médica de EE. UU. e India y bancos de preguntas de exámenes universitarios de biología.

“[Open Medical-LLM] permite a investigadores y profesionales identificar las fortalezas y debilidades de diferentes enfoques, impulsar mayores avances en el campo y, en última instancia, contribuir a una mejor atención y resultados al paciente”, escribe Hugging Face en una publicación de blog.

Créditos de imagen: abrazando la cara

Hugging Face está posicionando el punto de referencia como una “evaluación sólida” de los modelos de IA generativa destinados a la atención médica. Pero algunos expertos médicos en las redes sociales advirtieron que no se debe dar demasiada importancia a Open Medical-LLM, para que no se produzcan despliegues mal informados.

En X, Liam McCoy, médico residente en neurología de la Universidad de Alberta, señaló que la brecha entre el “entorno artificial” de las respuestas a preguntas médicas y actual la práctica clínica puede ser bastante amplia.

La científica investigadora de Hugging Face, Clémentine Fourrier, coautora de la publicación del blog, estuvo de acuerdo.

“Estas tablas de clasificación sólo deben usarse como una primera aproximación de qué [generative AI model] explorar para un caso de uso determinado, pero luego siempre se necesita una fase más profunda de prueba para examinar los límites y la relevancia del modelo en condiciones reales”, dijo Fourrier en una publicación en X. “Médico [models] Los pacientes no deben usarlos por sí solos, sino que deben capacitarse para que se conviertan en herramientas de apoyo para los médicos”.

Esto recuerda la experiencia de Google hace varios años al intentar llevar una herramienta de detección de IA para la retinopatía diabética a los sistemas de salud en Tailandia.

Como informó Devin en 2020, Google creó un sistema de aprendizaje profundo que escaneaba imágenes del ojo en busca de evidencia de retinopatía, una de las principales causas de pérdida de visión. Pero a pesar de la alta precisión teórica, la herramienta resultó poco práctica en pruebas del mundo realfrustrando tanto a los pacientes como a las enfermeras con resultados inconsistentes y una falta general de armonía con las prácticas sobre el terreno.

Es revelador que, de los 139 dispositivos médicos relacionados con la IA que la Administración de Alimentos y Medicamentos de EE. UU. ha aprobado hasta la fecha, ninguno usa IA generativa. Es excepcionalmente difícil probar cómo se trasladará el rendimiento de una herramienta de IA generativa en el laboratorio a hospitales y clínicas ambulatorias y, quizás lo más importante, cómo los resultados podrían evolucionar con el tiempo.

Eso no quiere decir que Open Medical-LLM no sea útil o informativo. La tabla de clasificación de resultados, al menos, sirve como recordatorio de cuán mal Los modelos responden a preguntas básicas sobre salud. Pero Open Medical-LLM, y ningún otro punto de referencia, es un sustituto de las pruebas del mundo real cuidadosamente pensadas.